论文阅读记录 —— LLM 相关

Learning to Reason and Memorize with Self-Notes

- 原文链接:Learning to Reason and Memorize with Self-Notes

- 发表:NeurIPS 2023

- 时间:2023

- 机构:Meta AI

研究动机(Motivation)

大型语言模型(LLMs)在多步推理任务中表现不佳,并且无法保留先前的推理步骤以供将来使用。这限制了它们在复杂问题解答中的性能。

解决的问题

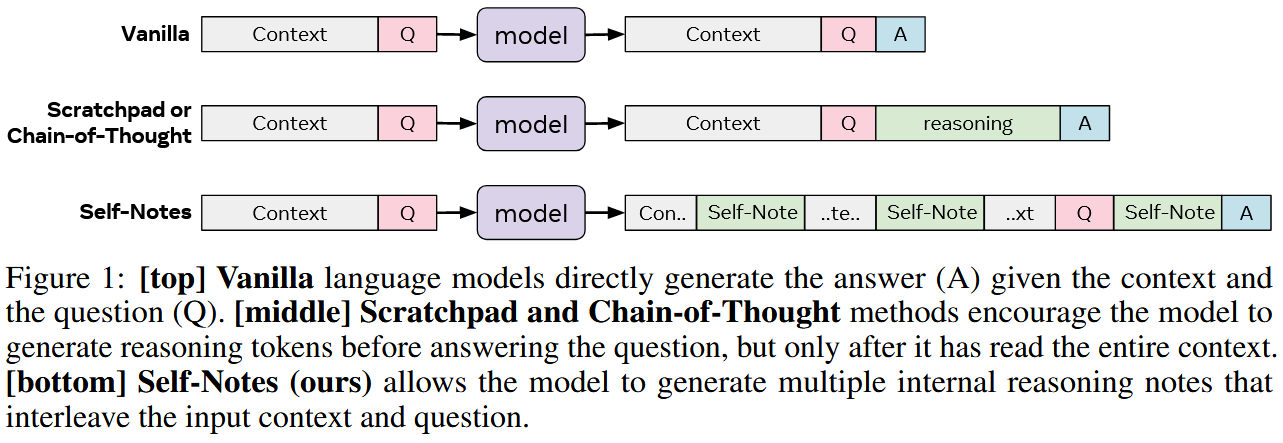

论文提出了一种名为“Self-Notes”的方法,旨在解决上述问题。这种方法允许模型在阅读上下文时,随时偏离输入内容生成明确的推理标记(即“Self-Notes”),以增强其记忆并实现多步推理。

方法

(需要微调)

- Self-Notes:与链式思维(Chain-of-Thought)或草稿板(Scratchpad)方法不同,Self-Notes 允许模型在任何时候插入与输入上下文和问题交织的内部推理笔记。

- 模型架构:考虑了一个自回归的变换器模型,该模型在生成最终输出之前,可以通过生成“笔记标记”来丰富上下文。

思考

- 优势:可以帮助语言模型更好地处理长序列或复杂任务,且不需要太多的监督信号。

- 关键思路:与草稿板方法不同,本论文中的模型可以随时偏离输入上下文以明确思考。这种方法允许模型在阅读上下文的同时回忆信息并进行推理,从而扩展其记忆并实现多步推理。相比当前领域的研究状况,这篇论文的思路在于通过自我笔记的方式来解决有限上下文记忆和多步推理的问题。

DUP

Achieving >97% on GSM8K: Deeply Understanding the Problems Makes LLMs Better Solvers for Math Word Problems

- 发表:https://arxiv.org/abs/2404.14963

- 时间:2024.5.29

- 机构:武汉大学 & 悉尼大学 & 南洋理工大学

摘要总结

大型语言模型(LLMs)在各种自然语言处理任务中表现出色,但在处理复杂的数学文字题时,它们的推理能力常常不尽人意。这类问题通常包含三种错误:语义理解错误、计算错误和步骤遗漏错误。尽管已有研究关注计算错误和步骤遗漏错误,但语义理解错误作为限制LLMs性能的主要因素,却被忽视了。

论文提出了一种简单但有效的方法,称为“Deeply Understanding the Problems”(DUP),通过解决语义理解错误来提高LLMs解决数学问题的能力。DUP方法的核心是鼓励LLMs深入理解问题,提取关键的解题信息,以进行更好的推理。

研究动机

尽管 LLMs 在各种自然语言理解和生成任务中表现出色,但它们在推理任务(例如数学推理、常识推理和符号推理)中的表现往往不尽如人意。CoT prompting 方法虽然能够显著提升 LLMs 的推理能力,但它在处理复杂数学问题,尤其是数学应用题时,仍然存在以下三个主要问题:

- 语义误解错误: LLMs 无法准确理解问题的核心内容,导致无法提取出解决问题的关键信息。

- 计算错误: LLMs 在进行计算时可能出现错误,导致最终答案不正确。

- 步骤缺失错误: LLMs 可能会遗漏解决问题的某个步骤,导致推理过程不完整。

现有的研究主要集中在解决计算错误和步骤缺失错误,而对语义误解错误关注较少。然而,语义误解错误是限制 LLMs 推理能力的主要因素。

因此,文章提出了一种名为 Deeply Understanding the Problems (DUP) 的方法,旨在通过解决语义误解错误来提升 LLMs 的数学问题解决能力。

方法

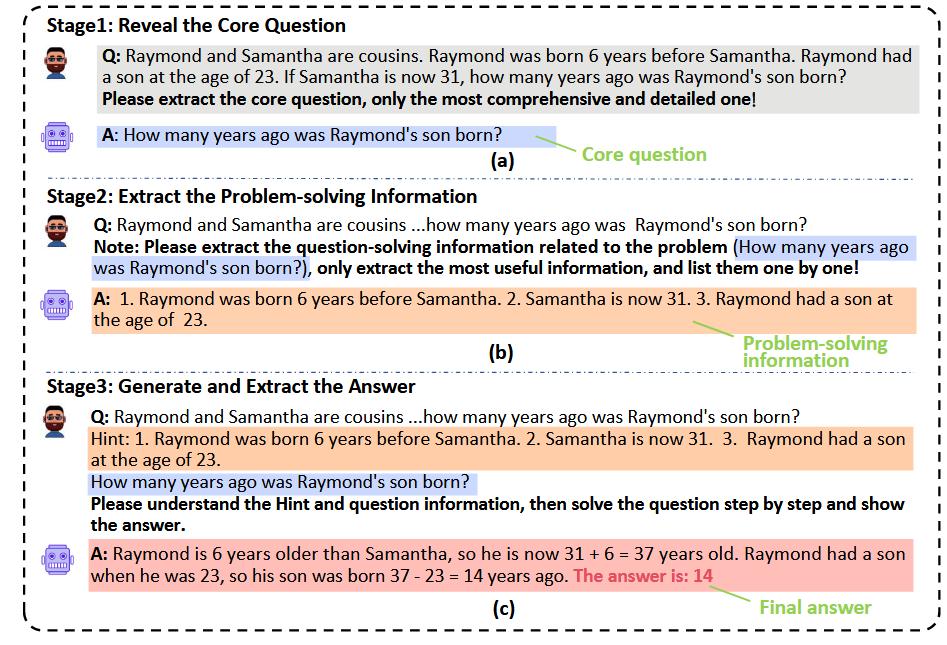

DUP(Deeply Understanding the Problems)方法是一种针对大型语言模型(LLMs)的提示策略,旨在提高它们解决数学文字题的能力。以下是DUP方法的详细步骤和特点:

-

揭示核心问题(Reveal the Core Question)

这是DUP方法的第一阶段,目的是从复杂和冗长的问题描述中明确问题的核心。通过设计一个提示,要求LLM明确提取问题的核心部分,从而帮助模型集中注意力于问题的目标。 -

提取解题信息(Extract the Problem-solving Information)

第二阶段进一步从问题描述中提取对解决核心问题至关重要的信息。这一步骤通过一个提示来实现,该提示要求LLM列出与核心问题直接相关的最有用的信息。 -

生成并提取答案(Generate and Extract the Answer)

在前两个阶段的基础上,第三阶段将核心问题和解题信息结合起来,生成详细的回答,并从中提取最终答案。这一步骤通过一个模板提示来实现,该模板明确指出了目标和解决问题所需的必要信息。

实验

- 数据集:

- 算术推理数据集: GSM8K、SVAMP、MultiArith、AddSub、AQuA、SingleEq

- 常识推理数据集: CommonsenseQA、StrategyQA

- 符号推理数据集: Last Letter、Coin Flip

- 基线方法:

- 零样本方法: Zero-shot CoT、Least-to-Most、Zero-shot PS+

- 少样本方法: Manual-CoT、Auto-CoT

- 实验设置:

- LLMs: GPT-3.5-Turbo 和 GPT-4

- 解码策略: 具有自一致性(SC)的解码策略(Wang et al., 2023b)

- 实验结果:

- DUP 方法在所有推理数据集上均取得了显著优于其他方法的性能。

- DUP 方法的零样本性能甚至超过了少样本方法的性能。

- DUP 方法在 GSM8K 和 SVAMP 数据集上取得了新的 SOTA 结果。

- 消融实验:

- 探究 DUP 方法中各个阶段的重要性。

- 探究如何在不降低性能的情况下降低 DUP 方法的推理成本。(将三阶段提示合并为一个提示)

- 讨论和分析:

- 分析 DUP 方法与 SC 解码的兼容性。

- 验证 DUP 方法是否可以应用于开源 LLMs。

- 分析更准确的核心问题和问题解决信息如何提升推理性能。

- 进行错误分析,验证 DUP 方法是否有效减少了语义误解错误。

Re-Reading Improves Reasoning in Large Language Models

重读能提升大模型推理能力

研究背景

本文旨在介绍一种简单有效的提示方法“重复阅读(RE2)”以提升大型语言模型(LLMs)的推理能力。这一方法受到人类在学习和解决问题时倾向于重复阅读问题以提高理解的观察启发。

研究目标和假设

本文旨在探讨重复阅读问题是否能提升LLMs的推理性能。关键假设是,重复阅读问题可以帮助LLMs更深入地理解输入,从而提高推理能力。

研究方法

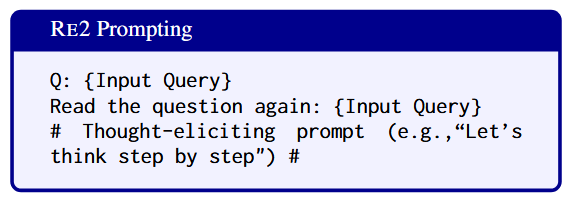

本文介绍了“RE2”提示方法,即在提示中重复两次输入问题。这可以作为一个“即插即用”模块,与各种诱导思考的提示策略(如思维链和程序辅助语言)集成使用。

结果和发现

论文评估了RE2在各种推理基准测试(包括算术、常识和符号推理任务)上的有效性。

研究结果显示,RE2 能够持续提升LLMs的推理性能,包括ChatGPT等指令微调(IFT)模型和 LLaMA-2 等非IFT模型。RE2与各种诱导思考的提示方法兼容,也可以有效地与少样本提示和自一致性方法相结合。

思考

很简单的方法,可以学习其写作技巧。